3 марта, 2017

Проверка временем: 8800 Ultra SLI

Введение

В прошлой заметке мы разобрались с поведением GeForce 9800 GTX+ и Radeon HD 4850 в старых и не очень играх на современной системе. Как оказалось, даже 512-мегабайтные карточки еще способны позволить вам поиграть в любимые тайтлы, пускай и на низких настройках графики. Пару дней назад в лаборатории overclockers.ru был опубликован всеобъемлющий материал об эволюции производительности видеокарт Nvidia от моего коллеги mishgane. Хотя акцент в той статье сделан именно на 8800 Ultra, это совсем не значит, что в исследовании легендарной видеокарты можно ставить точку. В частности, в стороне остался волнующий вопрос о производительности и масштабируемости SLI-связки из этих карт. Изучению потенциала GeForce 8800 Ultra SLI в современных реалиях и будет посвящен сегодняшний второй по счету выпуск “Проверки временем”.

Если взглянуть на технические характеристики 8800 Ultra и протестированной в прошлый раз 9800 GTX+, то обновленный флагман 9-й серии может похвастаться лишь более высокими частотами ядра/памяти и большим числом транзисторов. Впрочем, благодаря тонкому 55-нм техпроцессу их удалось разместить на чипе меньшей площади. На стороне «ультры», в первую очередь, больший объем памяти (768 МБ против 512 МБ) и почти на треть большая пропускная способность: 103,7 ГБ/сек против 70,5 ГБ/сек. Также Ultra имеет 24 блока растровых операций, тогда как у GTX+ из всего 16. Но достаточно ли простой математики для досрочного присуждения победы? Не стоит торопиться, ведь 126 МГц разницы в частотах ядра это довольно много, к тому же 754 млн. транзисторов находятся в чипе G92b не просто так, и новая модель наверняка получила различные аппаратные и программные оптимизации.

Однако у 8800 Ultra в этом обзоре есть напарник, готовый придти на помощь и разгромить требовательные до ресурсов игры! Но это в теории,… а что же будет на практике? Тестирование покажет.

Но сначала подробнее рассмотрим сегодняшних участниц.

Nvidia GeForce 8800 Ultra

Выход GeForce 8800 Ultra стал тем редким случаем, когда новинка выпускается не в ответ на решение конкурента или для упредительного удара по нему, а для замены собственного же флагмана и, соответственно, повышения цены. Тут, конечно, можно привести в сравнение пример с появлением первого GTX Titan, но он был нужен Nvidia для завоевания лидерства в условиях жесткой конкуренции с Radeon HD 7970 Ghz Edition, а в случае с 8800 Ultra конкуренции с AMD в топ-сегменте не было.

Релиз 8800 Ultra состоялся 2 мая 2007 года и заставил геймеров и энтузиастов с ужасом содрогнуться от стоимости новинки, составившей $829. Даже по сегодняшним меркам такая цена кажется очень высокой, а для 2007 года она и вовсе выглядела заоблачной.

Изначально планировалось установить частоту ядра «ультры» на отметке в 650 МГц, но в итоге ее решили снизить до 612 МГц, ибо даже обновленная система охлаждения с трудом справлялась с горячим нравом чипа G80. Сам чип, к слову, получил обновленную ревизию A3 и снизил энергопотребление на 2 Вт по сравнению с A2. Разгонный потенциал, напротив, возрос, так что 8800 Ultra стала желанным приобретением для оверклокеров. Еще одной особенностью «ультры», отличавшей ее от 8800 GTX, стала более быстрая и дорогая память GDDR3 от Samsung со временем выборки 0,8 нс и номинальным напряжением 1,8 В. Снижение напряжения памяти также позволило немного поубавить TDP (до 193 Вт).

Модернизированная система охлаждения получила вынесенный за пределы печатной платы вентилятор, который теперь мог забирать воздух с обеих сторон. Кроме того, такая конструкция придала 8800 Ultra уникальный и запоминающийся внешний вид. Кожух был продлен и теперь закрывал всю печатную плату, а вот сам радиатор практически не изменился и остался слабым местом всей СО.

К сожалению, ошибки технологического процесса производства видеокарт линейки GeForce 8000 не были учтены в новой модели. Речь тут, конечно же, идет о применении недостаточно пластичного бессвинцового припоя, из-за которого чипы при большом количестве циклов нагрева-охлаждения «отваливались» от подложки. Высокие рабочие температуры старших моделей усугубляли процесс, так что до наших дней дожило не так много видеокарт с индексом 8800, и с каждым днем их становится все меньше. Имея в своем распоряжении суммарно шесть видеокарт на чипах G80, три их них пришлось подвергнуть процедуре «прожарки» для восстановления BGA-контакта кристалла с текстолитом подложки.

Описание тестового стенда

Изменений в аппаратной и программной конфигурации тестового стенда со времени прошлого обзора не произошло. Единственный момент – кулер True Spirit 140 вернулся обратно на AMD-платформу, а его место на Maximus VI Gene заняла обновленная модель True Spirit 140 Power.

- CPU: Core i7-4770K @ 4.3 GHz (Haswell);

- Cooler: Thermalright True Spirit 140;

- MB: ASUS Maximus VI Gene (Z87);

- RAM: 2×4 GB DDR3 Samsung DH0 (1600 MHz CL8);

- HDD: Seagate Barracuda 7200.11 1.5 TB;

- PSU: OCZ ZT750 (750W);

- Case: открытый стенд собственного изготовления;

- ОS: Windows 7 Pro x64;

- Drivers: ATI Catalyst 13.9, Nvidia ForceWare 342.01 (декабрь 2016) и 310.90 (январь 2013).

Тестовые приложения и методика

Набор тестовых приложений так же не изменился, благодаря чему результаты 8800 Ultra можно напрямую сравнить с HD 4850 и 9800 GTX+, что и будет сделано на новых графиках. Напомню, что игры тестового набора выбирались из такого принципа, чтобы чреди них были как проекты периода выхода видеокарт (2007-2009гг.), так и более современные игры, выпущенные уже во время царствования на десктопах DirectX 11 (2011г. и далее).

Первая категория:

- Assassin’s Creed II – ноябрь 2009г.

- CoD Modern Warfare 2 – ноябрь 2009г.

- Crysis DX10 – ноябрь 2007г.

- Unreal Tournament 3 – октябрь 2007г.

- S.T.A.L.K.E.R.: Чистое небо – август 2008г.

Вторая категория:

- Age of Wonders III – март 2014г.

- Battlefield 3 – октябрь 2011г.

- Borderlands: The Pre-Sequel – октябрь 2014г.

- Far Cry 3 – ноябрь 2012г.

- The Elder Scrolls V: Skyrim – ноябрь 2011г.

- Shadow Warrior – сентябрь 2013г.

- Grim Dawn – февраль 2016г.

Во всех играх были выключены AA, AF и вертикальная синхронизация. Также Vsync был принудительно отключен в драйверах. Настройки графики для каждой игры выбирались так, чтобы испытуемые карты могли обеспечить хотя бы приемлемый уровень FPS. Пресеты отображены в скобках после названия игр на графиках. В S.T.A.L.K.E.R.: Чистое небо использовалось динамическое освещение только для объектов, в Borderlands: The Pre-Sequel было выставлено низкое качество физики PhysX.

Тестирование проводилось в двух разрешениях: 1280×1024 и 1920×1080.

Результаты

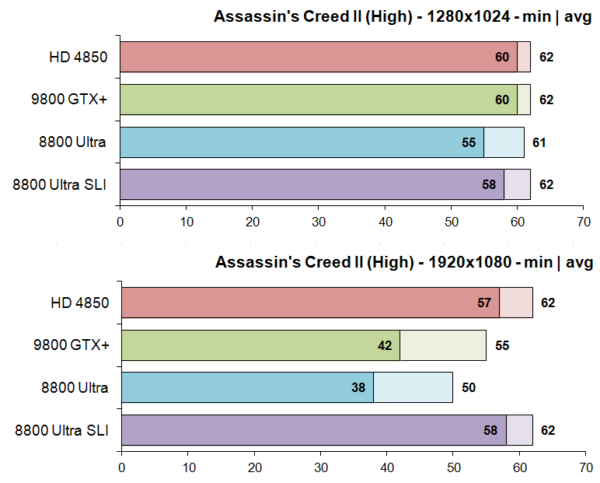

Assassin’s Creed II продемонстрировал неприятное падение FPS на 8800 Ultra при переходе к Full HD. На 9800 GTX+ тоже наблюдалось падение, но не такое сильное. Чтобы стабилизировать ситуацию пришлось звать на помощь вторую карту, и SLI-тандем смог вернуть производительность в зону комфорта. В игре используется принудительное ограничение кадров, так что 62 – это ее максимум.

Что касается Unreal Tournament 3, то эта игра оказалась настолько простым испытанием для всех тестируемых карт, что ее нет смысла даже выносить на графики. Как и в Assassin’s Creed II, там работает ограничитель на отметке 60 к/с (62 по показаниям Fraps).

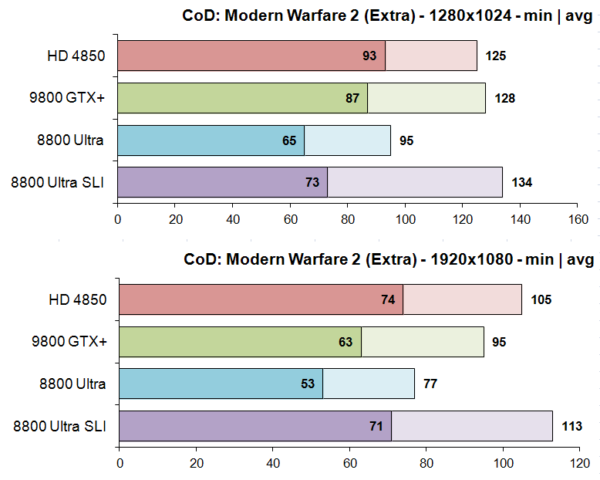

Call of Duty: MW2 неожиданно нанесла удар по “ультре”. В этой игре флагманская 8800 значительно уступила и 9800 GTX+, и HD 4850. Причины такого поведения непонятны, однако на помощь пришел режим SLI, где даже в разрешении Full HD частота кадров на Ultra смогла перешагнуть за сотню. Масштабируемость связки составила 33% и 46% по минимальному и среднему FPS соответственно. Конечно, можно включить VSync и даже на одной карте наслаждаться 60 FPS в 1920×1080 при максимальном качестве графики, но на то он и бенчмарк, чтобы показать абсолютные значения.

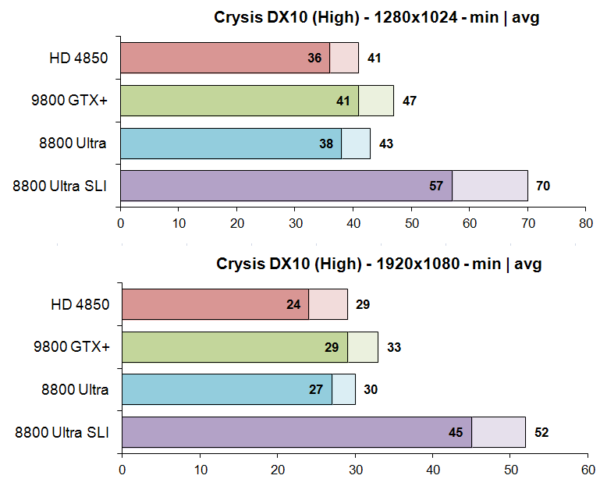

Результаты 8800 Ultra в Crysis расположились между HD 4850 и 9800 GTX+. При добавлении второй карты становится ясно, какая конфигурация требовалась геймерам в 2007 году, чтобы насладиться игрой в Full HD при высоком качестве графики. Конечно, у них не было Core i7, но все же будем считать полученные результаты заслугой видеокарт. Масштабируемость SLI в Full HD составила 66% и 73% по минимальному и среднему FPS соответственно, что является хорошим показателем.

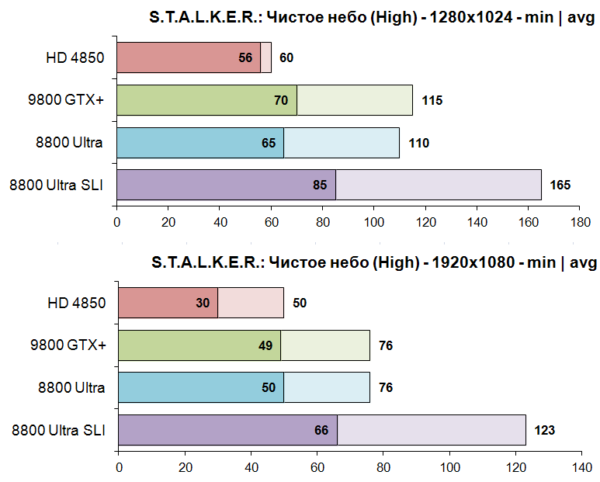

В S.T.A.L.K.E.R.: Чистое Небо 9800 GTX+ и 8800 Ultra вновь оказались практически равны, разве что в 1280×1024 первая чуть-чуть вырвалась вперед. SLI в игре заработал без проблем и показал масштабируемость 32% по минимальному и 61% по среднему FPS в Full HD. Не очень много, но когда средний FPS зашкаливает далеко за сотню, это уже не так важно.

Перейдем ко второй партии игр.

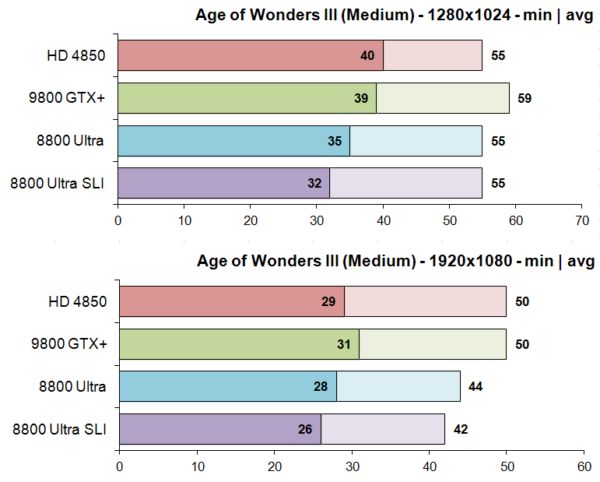

Если во всех старых играх технология SLI успешно работала и прибавляла заветные кадры, то Age of Wonders стала первой протестированной игрой, где вторая карта оказалась бесполезна. Более того, поскольку у Core i7-4770K линии PCI-E делятся поровну между двумя картами, каждая их них работала в режиме x8, что в данном случае повлияло на производительность. В Full HD SLI-связка обеспечивает на 2 к/с меньше, чем одиночная карта, установленная в слот x16. Если же говорить о производительности 8800 Ultra в общем, то старый флагман уступил около 4 к/с представителю 9000-й серии.

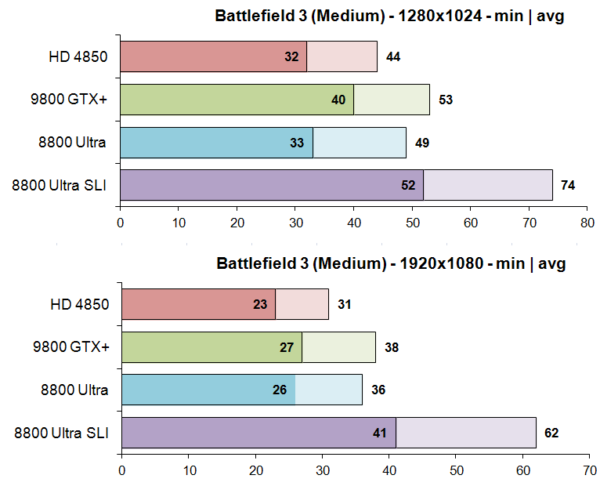

Изначально Battlefield 3 отказался работать со SLI-связкой на драйверах 342.01 – игра просто вылетала с ошибкой сразу после запуска. Решил проблему переход на более раннюю версию 310.90. Одиночная Ultra здесь расположилась между HD 4850 и 9800 GTX+, а SLI-связка показала неплохую масштабируемость в 57/72% в Full HD, что даже обеспечило больше 60 к/с по среднему значению! Можно с уверенностью заявить, что две 8800 Ultra позволят вам с комфортом провести время на поле боя при среднем качестве графики.

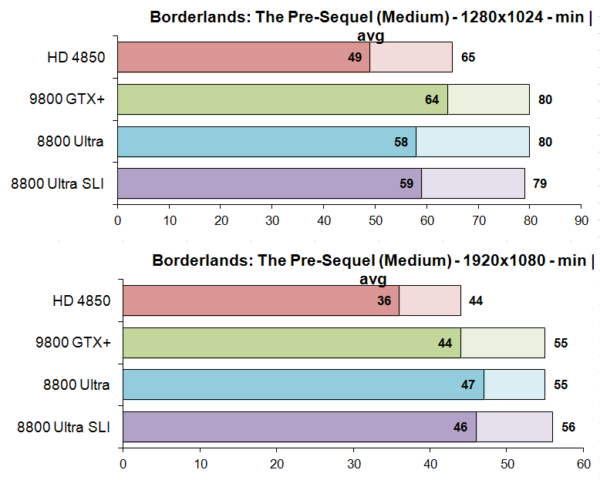

В Borderlands: The Pre-Sequel между 8800 Ultra и 9800 GTX+ установился паритет по среднему FPS. А вот SLI-связка в этой игре снова не заработала. Расхождение результатов двух карт и одной находится в пределах погрешности. Можно сказать, что снижение количества линий PCI-E с 16 до 8 не повлияло на производительность.

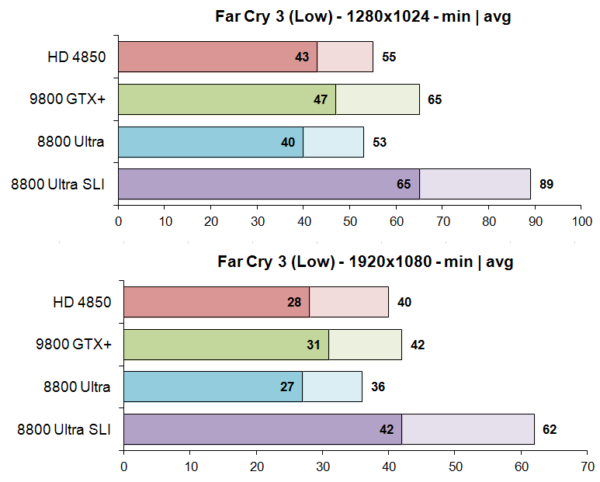

Одиночная 8800 Ultra откровенно не блистает в Far Cry 3, оказываясь медленнее конкурентов, однако SLI раскрывает ее потенциал. Прирост от добавления второй карты в Full HD составляет 55/72% по минимальному/среднему FPS, само же среднее число кадров в Full HD перешагивает отметку в 60.

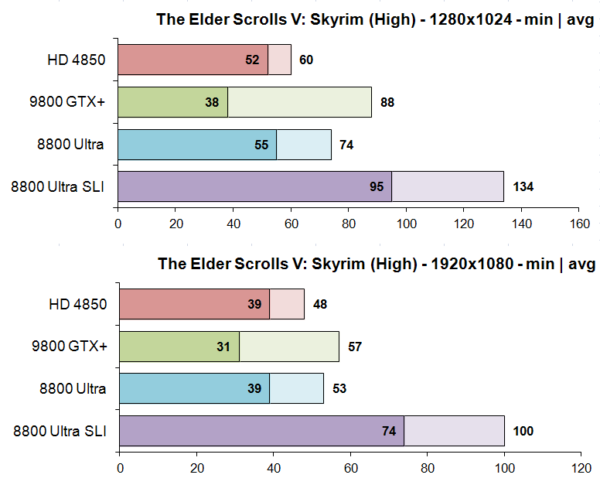

Skyrim помог 8800 Ultra частично реабилитироваться после поражений перед 9800 GTX+. Хотя по среднему FPS более новая карта все же впереди, но зато на Ultra не наблюдалось таких же сильных просадок кадров. Скорее всего, дело тут в большем объеме памяти, ведь в игре используется официальный набор текстур высокого разрешения. А вот SLI проявил себя во всей красе! Добавлением второй карты FPS в Full HD удалось увеличить на 89%!

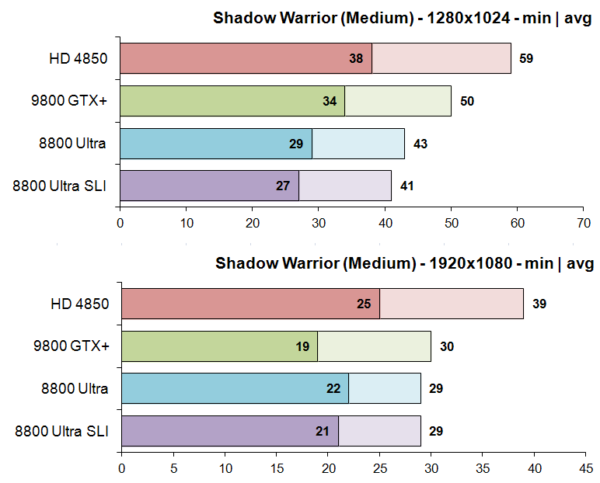

Shadow Warrior со средними настройками графики благоволит только Radeon. Ultra отстала от 9800 GTX+ в разрешении 1280×1024, но примерно выровнялась с ней в Full HD. Технология SLI вновь оказалась бесполезна, а снижение числа линий PCI-E отразилось только на частоте кадров в 1280×1024, да и то минимально. Как и Battlefield 3, эта игра оказалась капризной до драйверов и отказалась запускаться на версии 342.01. Пришлось устанавливать 310.90 четырехлетней давности, на них все заработало.

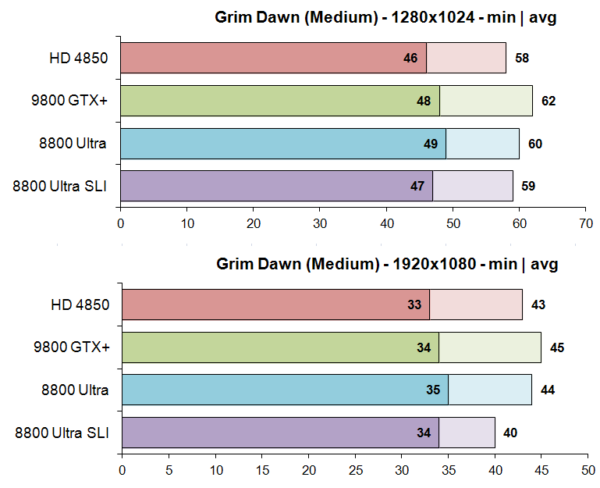

В Grim Dawn все испытуемые показали примерно одинаковые результаты. SLI здесь не работает, а от отсутствия восьми линий PCI-E больше всего пострадал средний FPS в разрешении Full HD – тут разница между режимами x16 и x8 достигла четырех к/с.

Бенчмарки 3DMark

| 3DMark Vantage Performance | 3DMark Cloud Gate | |

| Radeon HD 4850 | 9345 | 8445 |

| GeForce 9800 GTX+ | 8445 | 10038 |

| GeForce 8800 Ultra | 9139 | 9335 |

| 8800 Ultra SLI | 16082 | 14603 |

Среди “зеленых” карт Vantage отдает предпочтение 8800 Ultra, хотя выгоднее всех тут выступает Radeon. Более современный Cloud Gate однозначным лидером определил 9800 GTX+, следом за ней идет Ultra, а вот HD 4850 безнадежно отстала от видеокарт GeForce.

Выводы и заключение

Вопреки большей пропускной способности памяти и наличию 24 блоков ROP GeForce 8800 Ultra все же не смогла превзойти 9800 GTX+. Только в Skyrim 768 МБ быстрой памяти позволили ей показать лучший результат, в остальных же случаях “ультре” удавалось лишь обеспечить паритет, да и то не всегда. Большая частота ядра и внесенные в него оптимизации сделали свое дело и помогли GeForce 9800 GTX+ обойти предшественника. Конечно, нельзя исключать влияния на результат т.н. “драйверной магии”, впрочем, это материал для отдельного исследования.

SLI-тандем продемонстрировал прирост производительности в среднем на 50-70%. В старых играх проблем с работоспособностью технологии не возникло, а вот многие более новые проекты прохладно отнеслись к появлению в системе второй карты. Но тут ничего не поделаешь. Если SLI в игре не работает, то остается только принять это как факт.

Наконец, главный вопрос: можно ли рекомендовать GeForce 8800 Ultra к использованию в наши дни? Пускай по производительности Ultra не сильно отличается от 9800 GTX+, а две такие карты и вовсе обеспечат вам вполне комфортное времяпровождение в Crysis, Battlefield 3 или Skyrim, но проблема тут кроется в другом,… и речь совсем не о глюках драйверов определенных версий. Года три назад я сам использовал 8800 Ultra в качестве основной видеокарты в системе на s1366. Она позволяла вполне комфортно играть в Borderlands 2 и прочие менее требовательные игры до тех пор, пока у нее не отвалился чип. Видеокарты линейки 8800 печально известны своей высокой смертностью, а особенно сильно проблема “отвала” затронула именно модели GTX и Ultra, построенные на 90-нм чипе G80. Жесткая эксплуатация почти десятилетней карты может привести к ее быстрому выходу из строя, особенно если вы собираетесь объединить две или три таких в SLI. Во время тестирования даже при внешнем обдуве мощным 24-ваттным 120-мм серверным вентилятором температура карт на рабочем столе составляла около 65°, тогда как в играх легко доходила до 90° и выше. Все же, если вы являетесь счастливым обладателем этой, без сомнения, легендарной карты, лучше поберегите ее.

В следующем материале мы ненадолго оставим в покое унифицированные шейдерные архитектуры и заглянем еще дальше в прошлое, во времена фиксированного графического конвейера. А на сегодня это все, спасибо за внимание.